手机访问:wap.265xx.com

手机访问:wap.265xx.com无人驾驶汽车面临怎样的伦理问题?

无人驾驶汽车与其他人工智能产品相比,将会面对哪些独特伦理问题?如何解?

推荐一篇论文“信息安全风险防范与算法法则的价值原则”。

里面提到的“算法法则的价值原则”就是遇到的主要的伦理问题。而解决方法类似于艾萨克.阿西莫夫的“机器人三原则”:1、机器人不得主动伤害人类;2、满足第一条的情况下,机器人不得见人类受到伤害而不救;3、在满足一、二条的情况下,机器人不能自己伤害自己。

而对于无人驾驶汽车的算法原则,就是:1、不主动伤害原则;2、满足第一条的情况下,自保原则;3、满足第1、2条的情况下,最小伤害原则。

类似于人类在遇到紧急情况下的下意识动作:紧急刹车、打方向。不过这个“最小伤害原则”挺难于量化。

伦理问题并不是最重要的。

现在无人驾驶面临的最大问题就是法规问题,而无人驾驶法规又受到道德伦理的严重影响。

有句话:法律是最低限度的道德。

我们先猜测一下无人驾驶法规会如何落地?能从中得到一些答案。

方案一:法规允许封闭区域的无人驾驶。

因为封闭区域的限制,没有人车交织的复杂环境,基本上就避免了道德伦理问题。

或许会有人员闯入,但是这属于违法在先。如果从违法的行人,和车内乘客做选择,这样道德伦理风险还算比较小了。

方案二:法规要求无人驾驶车辆必须配备5G远程操控

现在很多Robotaxi在路试,取消安全员才是真正的无人驾驶。waymo第一个取消了安全员。

国内的文远知行,景骐在广州也获得了无安全员开展路试的许可证。

车内没有了安全员,但是配备了5G远程操控。

如果法规要求无人驾驶必须配备5G远程操控,实时监控车辆运行。那么就没有伦理风险,因为远程操控人员要承担责任。

如果不要求实时监控,仅仅在无人车发出警报,才接手处理,这里面伦理风险就很大了。毕竟无监控的无人驾驶,就是真正意义上的电脑自主做决策了。

方案三:设立无人驾驶安全评审机构,通过评审的无人车允许上路运行。

现在自动驾驶已经有了分级标准,但是还没有评审机构。

目前国内来说,每个自动驾驶测试基地,设置了简易的安全评审:测试一下跟车,变道,拐弯,超车这些简单场景。通过了就允许开展路试。

但是这样简易的安全评审肯定是不够的,如何建立一个完善的安全评审流程与标准?还在不断探索。

我们假设已经有了一个安全评审机构,法规规定通过评审的无人车可以上路运营。

如果无人车出了事故,可以甩锅给评审机构,是评审流程不够严谨。这样车企的责任转嫁一部分给评审机构了,就不会说出了事故由车企全责。

可以参考波音737MAX的处理,波音拿到了适航许可证,事故直接原因是软件问题(间接原因是设计不合理,软件来凑)即使是事故发生以后,波音也再次拿到了适航许可证。当然这款飞机没人买了。

但是从事故的责任来说,没有人为此负责,因为产品是按照流程设计的,通过了测试。产品缺陷,目前的普遍责任划分,一般都是员工个人无责,而是由公司担责。公司能担什么责任?无非就是赔点钱,负责人辞职(下岗也合理,拿了那么多钱,事情没做好,也不算严厉处罚)

======分隔线======

以上三个方案,可以确定就是无人驾驶法规落地的唯一选择。

我们再从法规分析无人车的道德伦理问题。

方案一,方案二是比较容易通过,也是车企大力推进的一个方向。道德伦理问题比较简单,我们着重讨论方案三。

方案三需要设置一套无人车安全评审流程与标准,其中肯定就会遇到道德伦理问题的抉择。

不去讨论太复杂,法规中也不会出现小孩老人该撞哪一个?这样的条文。

我认为无人车法规的核心只有一条:无人车禁止主动碰撞行人。(应该也包括自行车摩托车等弱势交通参与者)

主动被动是完全不同的两个概念。例如刹车不及撞人归为被动碰撞。为了躲避石头撞向行人,就是主动碰撞。

详细分析一下道德伦理风险。

场景就是:无人车行驶,前方突然落石,躲避石头会碰撞到行人,如果碰撞石头乘客会挂,选择撞行人同理。

先从人类驾驶员的角度分析,选择碰撞行人,狭义上属于故意杀人,但是法律上有紧急避险条款,即使驾驶员选择了碰撞行人,也只能算紧急避险,只能算交通事故。

无人车也是同理,选择哪一个,都是紧急避险。

但是前面说了,法规要求禁止主动碰撞行人。无人车按照法规,只能选择碰撞石头。

这样处理的结果也是比较公平的。乘客本来是有机会活下去,只可惜这个机会被行人消灭了。

另外,碰撞老人小孩的例子,因为法规禁止无人车主动碰撞行人。那么无人车就只能选择刹车,不能转向选择另外一个人。因为一旦转向,就违反了主动碰撞行人法规。没有其他办法,真的没刹住车,也就这样了。

这样法规才会简洁可行,否则加入太多伦理判断,既违反人性,也不具备可操作性。又因为法规规定,道德伦理问题就甩锅给法规了。

======分割线=======

无人驾驶法规最终一定会落地,法规绝对不会出现复杂的伦理判断条文。(例如小孩老人撞哪一个之类的)

方案一,方案二后期肯定会通过。至于方案三,如果无人车无法展现高度的安全性,出于谨慎的考虑,可能方案三很久很久也不会被法规通过。

感谢邀请。

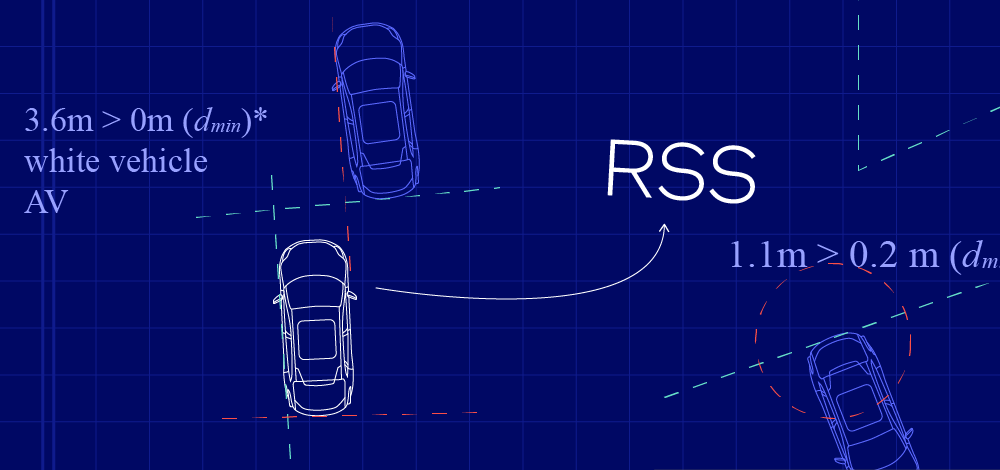

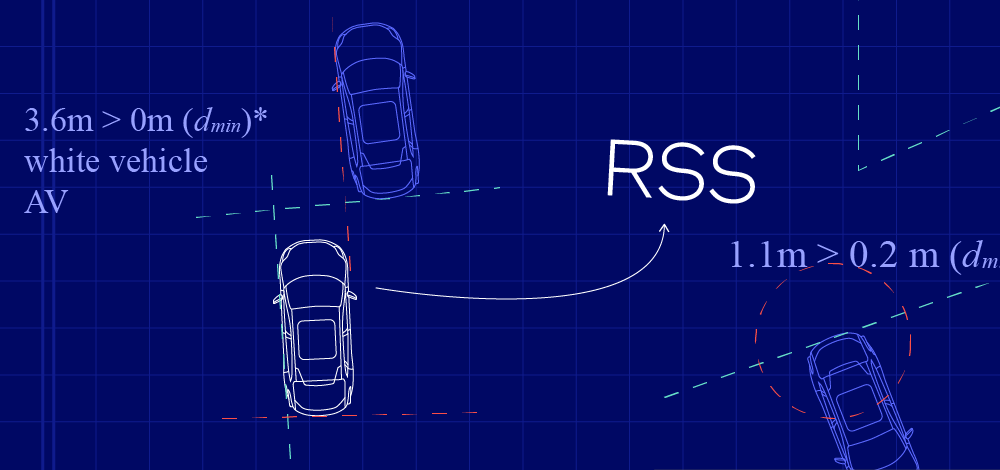

Mobileye开发了一个名为RSS (Responsibility Sensitive Safety) 的责任敏感安全模型,以期通过数学的方式来界定“安全状态”。

其目标是通过一些数学公式从理论上来保证自动驾驶汽车的安全行驶,并通过形式化以下人类驾驶中比较具有主观性的几个常识确保自动驾驶汽车永远不会主动导致事故发生。

Jack Weast对《AutoR智驾》表示,“为什么我们今天会和中国这两家大学研究机构之间的成立合作研究中心,也是因为我们觉得RSS确实需要完善,在加州做路测,其实路况还是要好得多,但是在中国这样一种更加高级复杂化的路况之下做路测,对使得RSS的安全场景更全面,一般来说,我们必须达到自动驾驶的三级以上,三到四级,这个时间点是2020年左右,但从现在到2021年之间,RSS还需要做大量的路测。”

根据英特尔中国研究院介绍,RSS模型要达到的目标具有两重含义(以下内容来自英特尔中国研究院):

1)自动驾驶汽车本身不会导致事故(卷入事故和导致事故是完全不同的概念,如上文提到的例子,自动驾驶汽车可能卷入事故,但它不是事故的责任方)。

2)自动驾驶汽车应该在其它车辆发生错误时做出正确反应.

也就是说RSS要做的就是在事故发生前设定游戏规则,主要用于自动驾驶系统中的决策部分,可以让其它OEM厂家将此模型直接放入他们的决策系统,从而促进行业标准,提高自动驾驶的整体安全。

4个“常识”判断责任方

对此,RSS通过形式化以下4个“常识”规则来确定“谁需要对事故负责”:

1)追尾不是前车的责任,后车必须保持足够的安全距离。

2)除非前车突然并线,红车突然插入黄车的车道导致追尾,责任在红车。

3)不要刻板地使用“路权”(“right-of-way” is given not taken)。如果某辆汽车违反了交通规则进入自动驾驶汽车拥有路权的道路,但自动驾驶汽车有足够的时间刹车避免事故,则它必须刹车,而不能由于自己的路权高而向前冲,否则就要承担责任。

4)小心被遮挡区域,小孩可能会被前车遮挡。

RSS是形式模型,需符合以下标准:

合理性:当RSS模型认为事故中自动驾驶汽车没有责任时,它必须符合人类判断的常识。

实用性:我们可以制定出一些不会导致事故的驾驶规则,即便事故发生,也可以明确不是自动驾驶车辆的责任。比较极端的做法是车辆一旦遇到意外情况就立刻停止,但是这种车是没用的,我们必须保证道路的通行能力。

什么是安全距离

安全距离是指在最恶劣的情况下仍可以避免碰撞的距离。最恶劣的情况是指前车以最大刹车加速度开始刹车,后车发现后有一定的反应时间,并在反应时间内仍以最大加速度前进,然后改成以最小刹车加速度刹车,直到危险解除。因此,最小安全距离的计算公式如下:

参数:Vf前车速度,Vr后车速度,反应时间ρ、最小刹车加速度αmin,brake、最大刹车加速度αmax,brake以及最大加速度αmax,accel。

说明:

*上述公式中的参数应该是法规制定的合理值

1)人类驾驶汽车和自动驾驶汽车的参数可以不同。比如自动驾驶汽车的反应时间一般会比人类短,而且自动驾驶汽车可以比人类驾车的刹车更有效。因此,自动驾驶汽车的αmin、brake可以设置得更大些。

2)不同路况下可以设置不同的参数(湿滑路面、冰、雪等)

相对行驶、横向移动等情况都会涉及不同的安全距离的计算方式,这里不再赘述。

路权

多条道路交叉或汇合时就会涉及到路权。

有些道路的优先级高于其他道路,在这些道路上行驶的汽车就拥有路权。RSS模型涉及到部分场景的解决方法,后期仍然需要扩展模型,并对安全距离的计算进行必要调整。

为了更好地理解路权,我们需要先定义一个名词:纵向顺序(Longitudinal Ordering),用来代表距离交叉点的直线距离。如下图所示,左图中,在纵向顺序上红车在蓝车前面,因为Dred < Dblue;右图反之。

和上文提到的公式化安全距离一样,我们同样可以定义多道路交叉时的纵向安全距离。如下图所示,红车拥有路权,优先级高,那么蓝车必须在进入路口前的安全距离内进行刹车,从而保证红车正常行驶。

如前文所述,RSS并不是刻板地以路权做为唯一判断,比如在下图中,蓝车来不及刹车闯入了红车的车道,红车也要采取刹车以避免碰撞。

甚至,RSS模型还可以支持轻微横向位移来避免撞击,如下图所示:

行人和遮挡

对于行人,首先需要明确行人的路线和优先级。某些地方行人的路线很明确,如人行道或者交叉路口的斑马线。这些地方自动驾驶汽车在自己车道上行驶时,一般无需担心行人会突然闯进来,车有优先权,但是也必须遵循灵活运用路权的原则。

但在有些地方,如居民区内,行人路线不明确,这时必须谨慎驾驶,给行人更高的优先权。考虑到人类的反应时间大概是500ms,最大加速度是2m/s2(博尔特的加速度是3.09m/s2)。那么,根据之前的公式,车辆与行人之间的安全距离是50cm,行驶时必须保证处于这个安全距离之外。

另外,需要格外注意有遮挡的环境。下图中的车辆正在通过一排停车位,一名儿童突然以速度10km/h的速度跑过来(比如在追球)。根据计算,10km/h的速度必须要保持15m的安全距离才可能避免碰撞发生。但此时汽车侧方的视野只有0.3m,显然无法满足安全要求。在这种情况下,RSS模型做了如下定义:

在车辆可以发现目标的第一时间(Te)到反应时间结束时(Te + ρ),车辆没有加速,且到发生撞击或者完全停下来的时刻(Ts),车辆一直以不低于αmin,brake的加速度在刹车

从Te到Ts这段时间内,车辆的平均速度低于行人的平均速度

这种情况下车辆是没有责任的。这个定义隐含的论点是:在发生撞击的时刻,车辆的速度比行人的速度低,或者两者都移动得很慢,从而使撞击的伤害降到最低。

RSS模型通过语义方式来描述测量结果、操作空间等,来指导无人驾驶汽车的规划、感知和动作。

这种语义可以理解为我们学交规时的驾驶规范。

例如,它不会做出这种描述:以当前速度开13.7米,然后以0.8m/s2的加速度加速前进,而是会发出语义指令,如“跟随前车”或者“从左侧超车”。

与人类驾驶类似,RSS提供的这个语义模型,并不是加速度矢量的几何运算,而是关于纵向或者横向目标的描述。

这对降低规划的运算复杂度(不会随着时间或邻车数量的增加而呈指数上升)、提升安全性和舒适性交互、以及传感器融合方面都至关重要。由于采用了语义模型,离线验证数据库只需要10^5量级的驾驶数据,就可以保证RSS模型达到死亡率10^-9次/小时的安全要求。

RSS模型的开发者,Amnon Shashua教授(英特尔子公司Moblieye公司首席执行官兼首席技术官)曾说: “世界上最优秀的人类也无法避免超出他们控制能力的事故,自动驾驶汽车亦然。但是最负责、最老练、最谨慎的司机,不太可能由于自己的过失导致事故,特别是像自动驾驶汽车拥有360度视力和闪电般反应速度的话。”

作为无人驾驶厂商,最不应该将无人驾驶置于伦理问题中。

焦点应该是如何为无人驾驶系统设计交通规则,无人驾驶需要做的是严格遵守交通规则。

交通规则通过路权优先级定义,组织好车辆的有序运行。如果车辆都能严格遵守交通规则,那么就能从前期预防了事故的发生,而避免陷入伦理问题。无人驾驶技术的研发出发点也是提升交通安全,而不是保护某类人的交通安全。

想象一下,你在十字路口停下车,你拥有路权,路口看起来也很安全。但你还是踩下刹车踏板,谨慎前进。幸好是这样,因为另一个司机没有让路,且随后一个你视野盲区的行人从停在路边的货车后面走了出来。

如果你在接近十字路口时合法遵守成文的道路规则,只根据观察到的情况行事,就可能会撞到那名司机和/或行人。但作为一名经验丰富的司机,你凭借直觉,注意到了不成文的道路规则。

Mobileye深知这些不成文的“规则”与正式规则同样重要,所以将其编入了责任敏感安全模型(RSS?)—— 一个开放、全面、可验证的自动驾驶汽车安全数学模型,从而有利于自动驾驶汽车与人类驾驶员安全共享道路,以便在全球范围内大规模部署自动驾驶汽车。

应用责任敏感安全模型(RSS?)的前提是:该系统能够处理大多数日常驾驶任务以及“边缘状况”,使自动驾驶技术更加安全实用。

也就是说,责任敏感安全模型必须能够在固有的不可预测的驾驶环境中(至少在自动驾驶汽车与人类司机共享道路的情况下)处理突发事件。

因此自动驾驶汽车需要设定一套参数,以此评估其所有的决定。

这些决定不是简单地控制车辆的运动或严格遵守交通法规,而是在一个全方位的自动驾驶汽车安全框架中,使自动驾驶汽车能够处理可能出现的任何情况,甚至是无法预测的情况。

为应对上述挑战:RSS将驾驶的直觉技能编纂成了5条包罗万象的规则:

● 规则1:不要追尾。

● 规则2:不要贸然加塞——类似于规则1中的纵向安全距离,但此应用于车辆之间的横向距离。

● 规则3:不要刻板使用路权——提醒自动驾驶汽车注意:其他车辆可能不会在应该让路的情况下让路。

● 规则4:不要在视野受限的区域冲动行事——车辆的传感器不能检测到所有潜在的危险,所以没有检测到并不等于安全。

● 规则5:如果可以避免碰撞,就必须不引发另一次碰撞——因为最终目标是防止碰撞发生。

我们相信,只要遵循RSS五条规则,自动驾驶汽车就不太会造成事故,并且会对可能遇到的任何潜在危险情况作出安全且适当的应对。

为证实这一观点,我们已经对RSS开展了独立审查,并将继续邀请工业界、学术界和政府的外部成员来确定遵循RSS规则后自动驾驶汽车仍然无法处理的情况。

RSS源于Mobileye三位领军人物2017年发表的一篇关于自动驾驶汽车安全的研究论文,但目前,其在现实世界的应用已经远远超出了学术范围。

RSS构成了格外精简的驾驶策略的基础,我们的自动驾驶汽车遵循这种策略。我们基于RSS的驾驶策略并不奢望确定所有可能发生的情况,而是将重点放在可能发生的情况上。

为此,该策略需要在现实可能性的范围内不断计算合理的最坏情况假设,很像人类的驾驶方式。

这种“精简”的计算过程应用在了我们高效、紧凑的EyeQ?系统集成芯片上,使自动驾驶汽车能够在所有真实世界的场景(不仅是在有限的地理区域,而是在世界各地的驾驶条件和行为差异很大的地方)中都能瞬间作出合理的决策。

无论相关技术多么优秀、多么值得信赖,为使自动驾驶汽车正确地运行还需要开展更多的工作。如需大规模部署自动驾驶汽车,具备行驶条件的道路不可或缺。

这意味着政府监管机构需要调整几十年来为人类驾驶车辆制定的规则,以覆盖到自动驾驶汽车。

RSS在这方面的贡献不容小觑:它不仅告诉了监管部门,而且还向其展示了基于RSS的自动驾驶技术在开放道路上的安全性,从而使监管部门、政策制定者和其他利益相关方能够在为自动驾驶出行铺路时作出明智的决定。

RSS还具有适应性:各司法管辖区甚至可以定制模型来适应当地的道路和驾驶文化。例如:一个国家可能会优先考虑安全问题,规定自动驾驶汽车与其他车辆保持更大的距离。而另一个国家可能会强调让自动驾驶汽车更完美地融入日常交通。那么RSS就可以满足这种差异化的要求,与其根据当地情况决定速度限制如出一辙。

但可以说,与任何单独的应用程序或参数相比,责任敏感安全框架更多的是通过透明度产生信任感。我们相信,新型交通的时代已经到来,而世界正需要用这种信任去迎接未来。

最近更新娱乐资讯

- 获奖影评赏析|《阿丽塔·战斗天使》

- 人生必看十部好看的纪录片(十部必看的现实主义纪录片)

- 日本十大禁欲动漫盘点:唯美霸道下的污镜头

- 墨西哥大麻即将合法化,美媒:美国夹在两个“卖大麻的邻居”之间

- “和合”文化背景下昭君文化的价值生成

- 马来酸阿法替尼片人体生物等效性试验

- 原创《满城尽带黄金甲》:喧哗与沉静的戏台,道德与伦理的悲歌

- 裴旖旎

- 隐适美附件又掉了,从第一天掉了2颗,第二天掉了1颗,今晚我还戴牙套吗?

- 电视剧《最美的青春》:好作品是如何炼就的

- 狗头萝莉出摊卖煎饼大家怎么看?

- 记者的职业伦理:我该何时放下相机

- 绝命毒师电影,「蚁人」改造DNA,首部Netflix华语剧...10月流媒体片单

- 这是一部非常独特的「成人动画」,少儿不宜

- 高分电影推荐!六部直击人性黑暗面的韩国片!部部引人深省!

- 2022天津解放军464医院整形美容中心整形价格表(价目表)全新发布

- 精 [电影推荐]一再婚女人因拯救女儿,让两个家庭面临人性考验,此电影令人感动

- 缓冲晶体溶液与生理盐水对重症监护病房患者急性肾损伤的影响:SPLIT随机临床试验

- 未成年人千万别看这部片子,简直太变态了!!!

- 生态在文学中的位置

- 与3800多名女性发生过关系,世界小电影之王,终于那啥了

- 新加坡电影《爸妈不在家》爆冷获多项金马奖

- 调查称52%受访者认为国产电影色情暴力问题严重

- 红楼梦初中读书笔记

- 家庭伦理剧,小品剧本《家庭矛盾》